A Universidade Stanford lançou gratuitamente no YouTube o curso “CME295: Transformers & Large Language Models (LLMs)”, voltado a quem deseja compreender em profundidade como funcionam os modelos de linguagem que impulsionam tecnologias como o ChatGPT e o Gemini. Ministrado pelos professores Afshine Amidi e Shervine Amidi, o curso cobre desde fundamentos de Natural Language Processing (NLP) até técnicas avançadas de raciocínio e agentes inteligentes baseados em IA.

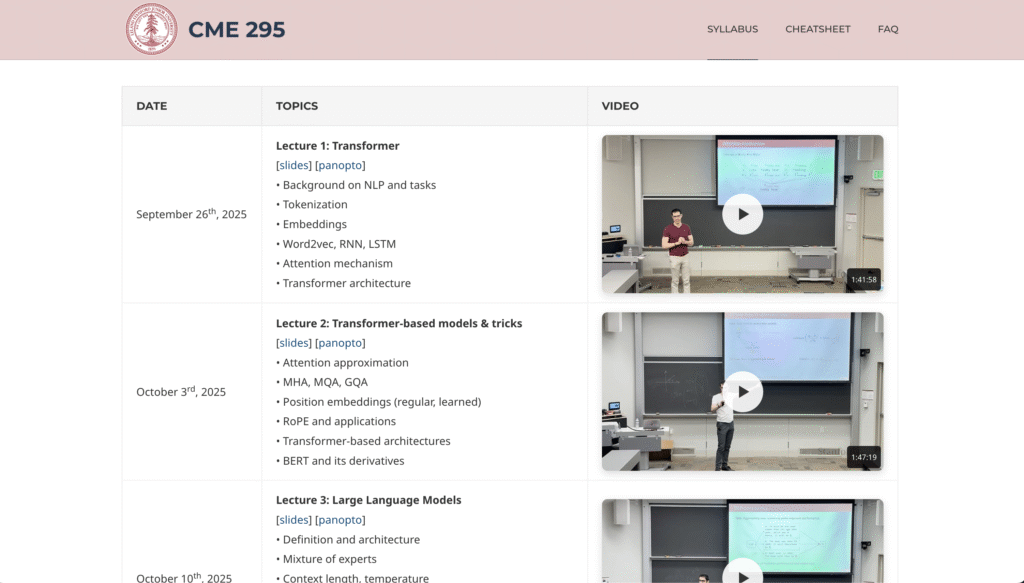

O programa é dividido em nove aulas publicadas entre setembro e dezembro de 2025, com slides e materiais complementares disponíveis no site oficial (cme295.stanford.edu/syllabus).

Nas primeiras aulas, Stanford revisita os principais conceitos de NLP, como tokenização, embeddings, Word2Vec, RNNs, LSTMs e a arquitetura Transformer — base dos grandes modelos modernos.

Em seguida, os professores exploram modelos derivados como o BERT, explicando mecanismos como multi-head attention, RoPE, positional embeddings e layer normalization.

As aulas posteriores avançam para o universo dos Large Language Models (LLMs), abordando tópicos como mixture of experts, prompting, in-context learning, chain of thought, quantização, afinamento supervisionado (SFT) e técnicas de RLHF (Reinforcement Learning from Human Feedback). O curso ainda dedica encontros a temas emergentes, como modelos de raciocínio, agentes de IA, retrieval-augmented generation (RAG) e avaliação de LLMs multimodais.

Com linguagem acessível e forte embasamento técnico, o CME295 oferece uma visão abrangente sobre a evolução e o futuro dos modelos de IA, combinando teoria e prática em um formato aberto, gratuito e produzido por uma das universidades mais prestigiadas do mundo.

📺 As aulas estão disponíveis no canal Stanford Online no YouTube.